SEO alanında iyi işler yaparak sitelerinizi yükseltmek istiyorsanız, uğraşmanız gereken bir çok teknik terim sizleri bulacaktır. Bu teknik terimlerden en önemlilerden biri de “robots.txt” olarak bilinmektedir. SEO uzmanı olmak için bu terimi iyi bilmek ve işlevlerini iyi yapmak gerekmektedir.

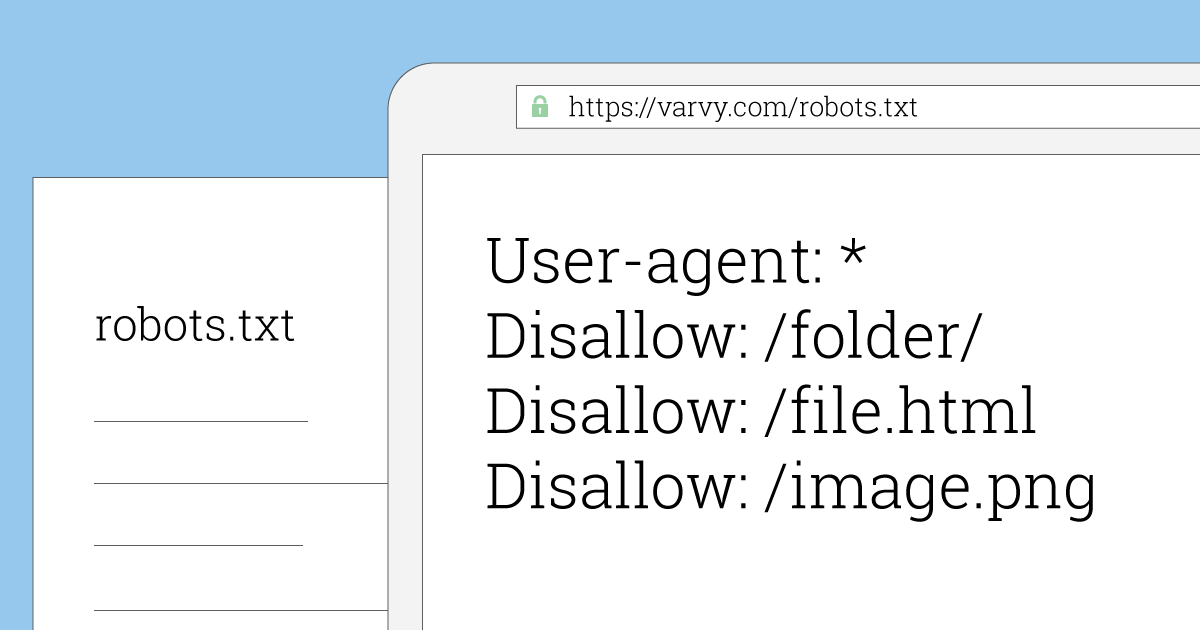

Robots.txt basit bir komut dosyası olarak bilinmektedir. Bu komut dosyası ile birlikte arama motorlarının sizlere nasıl işlevsel olarak yardım edeceğinin yöntemlerini belirlersiniz. Arama motoru yazılımları sizlerin sitenize geldiğinde ilk olarak robots.txt dosyasını tarayarak bu dosyada yer alan komutlara göre sitenizin izin verilen sayfaları ekleyebilir ve tarama gerçekleştirir. Yani, robots.txt dosyasıyla birlikte sitenizin sınırını belirleyerek sizleri taramaya gelen arama motoru botlarının sınırını bulabilirsiniz. Kendi web sitenizin belli alanlarını arama motoru botlarına kapatmak isterseniz sizlere yardımcı olacak şey robots.txt dosyasıdır. Bu dosya içerisinde yer alan komutlar arama motorları tarafından belirlenen botlara yön vermektedir. Arama motorları botları da bu komutlara uyarak sizin istediğiniz yerlere erişim sağlar ve sitenizin özgünlüğünü kontrol eder.

Herhangi bir sitenin robots.txt dosyasını indirerek analiz edip işe başlanması gerekmektedir. Hangi dosyanın indirilmesine izin verildiğini öğrenebilmek amacıyla bu dosyanın (robots.txt) dosyası kullanılarak kurallar içerisinde analiz edilmektedir. Belirlenen txt dosyası buna izin veriliyor ise sitenin adresinin URL’si indirilmektedir. İndirilen sayfanın içeriği analiz edilerek tüm iç linklerin listesi ortaya çıkarılmaktadır. Tüm iç bağlantılar sırayla indirildikten sonra analiz edilir. Arama motorları yeni linkleri bulamayıncaya kadar analiz işleminin devam ettiğinin unutmayınız.

Robots.txt için kullanılan komut listeleri aynı formatta olması gerekiyor. Dana önce belirlenen komut listeleri istenilen kök dizininde bulunması gerekiyor. Son olarak robots.txt dosyasının UTF-8 karakteri ile kodlamasına uygun yapılması gerekir. Kullanılan komutlar şu şekildedir;